SuperOffload:在超級晶片上釋放大規模 LLM 訓練的強大潛力 ![]()

太長不看:在單個 NVIDIA GH200 上高效地對 GPT-OSS-20B 和 Qwen3-14B 模型進行全引數微調,以及……

當量化不足時:為何 2:4 稀疏性很重要 ![]()

太長不看:將 2:4 稀疏性與量化結合提供了一種強大的方法來壓縮大型語言模型……

Mohammad Mozaffari, Jesse Cai, Supriya Rao2025 年 10 月 6 日

TorchAO 量化模型和量化方案現已在 HuggingFace Hub 上可用 ![TorchAO Quantized Models and Quantization Recipes Now Available on HuggingFace Hub]()

PyTorch 現在透過與 Meta 合作提供 Phi4-mini-instruct、Qwen3、SmolLM3-3B 和 gemma-3-270m-it 的原生量化變體……

在 Intel CPU 上使用原生 PyTorch 進行高效能量化 LLM 推理 ![]()

PyTorch 2.8 剛剛釋出,帶來了一系列令人興奮的新功能,包括……

Intel PyTorch 團隊2025 年 9 月 17 日

PyTorch 2.8 為 Intel GPU 帶來原生 XCCL 支援:來自阿貢國家實驗室的案例研究 ![]()

Intel 宣佈 PyTorch 2.8 在分散式訓練方面取得了重大增強:原生整合……

Intel PyTorch 團隊, 阿貢國家實驗室2025 年 9 月 12 日

PyTorch 2.8+TorchAO:在 Intel® AI PC 上釋放高效 LLM 推理 ![]()

大型語言模型 (LLM) 已經徹底改變了我們撰寫和消費文件的方式。在過去……

Intel PyTorch 團隊2025 年 9 月 3 日

使用 TorchAO、MXFP8 和 TorchTitan 在 Crusoe B200 叢集上將 2K 規模的預訓練加速至 1.28 倍 ![]()

太長不看:使用 MXFP8 將訓練加速 1.22 倍 - 1.28 倍,與 BF16 相比收斂性相同。我們最近……

DRAMA 模型推理效率提升 1.7 倍至 2.3 倍 ![]()

太長不看:NJT(巢狀鋸齒張量)將 DRAMA 模型推理效率提升 1.7 倍至 2.3 倍,使其更……

Shreya Goyal2025 年 8 月 22 日

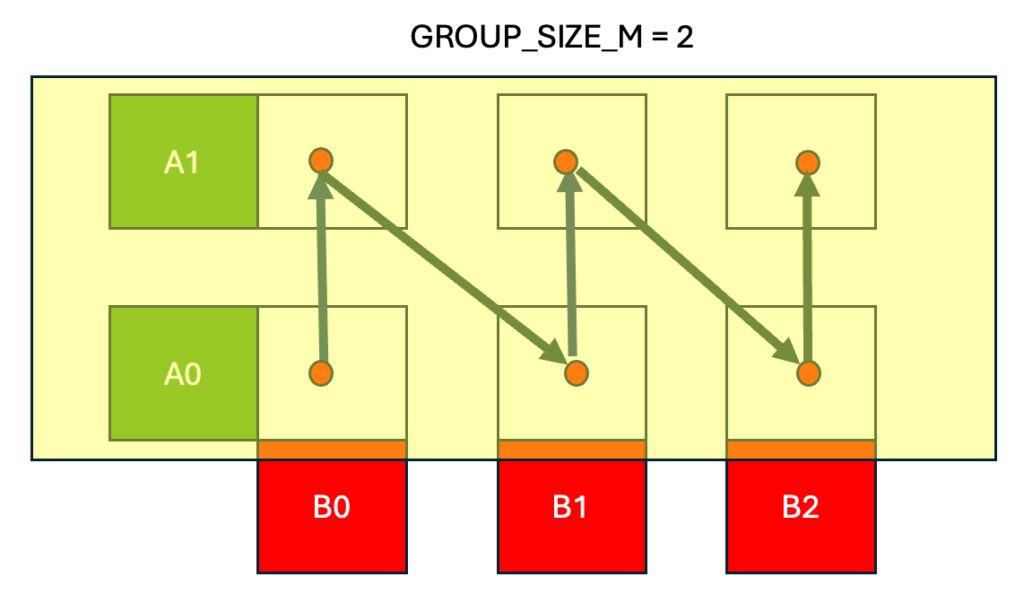

使用 Triton 持久快取感知分組 GEMM 核心加速 MoE ![]()

在這篇文章中,我們介紹了用於執行訓練的最佳化 Triton BF16 分組 GEMM 核心……

Less Wright, Adnan Hoque, Garrett Goon2025 年 8 月 18 日

PyTorch Wheel 變體,Python 打包的前沿 ![]()

uv 的建立者 charliemarsh 的推文:PyTorch 是用於開發和……的領先機器學習框架。

Eli Uriegas2025 年 8 月 13 日

PyTorch Day China 回顧 ![]()

2025 年 6 月 7 日,PyTorch Day China 在北京舉行,由 PyTorch 基金會聯合主辦…

PyTorch Foundation2025 年 8 月 12 日

Opacus 中引入混合精度訓練 ![]()

引言 我們將混合精度和低精度訓練與 Opacus 整合,以實現更高的吞吐量和訓練……

Iden Kalemaj, Huanyu Zhang2025 年 8 月 12 日