2025年6月7日,PyTorch Day China 在北京成功舉辦,由 PyTorch Foundation 和北京智源人工智慧研究院 (BAAI) 聯合主辦。為期一天的會議共進行了16場演講,平均每場會議有160名參會者。瀏覽完整的 YouTube 播放列表,查詢您感興趣的會議。

PyTorch Foundation 執行董事 Matt White 深入闡述了 PyTorch Foundation 致力於加速開源 AI 的承諾。基金會自兩年前成立以來,已發展到30名成員,並演變為一個傘形基金會,能夠託管 PyTorch 核心之外的開源專案。vLLM 和 DeepSpeed 成為基金會旗下的首批專案,BAAI 的開源專案 FlagGems 也加入了 PyTorch 生態系統。為支援本地社群發展而啟動的 PyTorch 大使計劃在一個月內收到了200多份申請。Matt 還介紹了 PyTorch 新網站,以及 PyTorch 大會和開源 AI 周的日程安排。他提到了基金會即將推出的舉措,包括演講者名錄、大學合作和培訓認證,並感謝了與會者,表達了對當天演講的期待。

2. 在多樣化 AI 晶片上執行大模型:PyTorch + 開源堆疊 (FlagOS) 實現無架構部署

北京智源人工智慧研究院副院長林詠華討論了當前在多樣化 AI 晶片上執行大模型的現狀。她解釋了構建統一開源系統軟體堆疊的原因:大模型面臨成本高昂、資源需求巨大以及訓練/推理昂貴等挑戰,而碎片化的全球 AI 加速器生態系統又帶來了額外問題。隨後,她介紹了由智源研究院與多個合作伙伴共同開發的 FlagOS,包括核心元件和必要工具,支援各種底層晶片和系統部署架構,以及多種大模型。它已獲得多種架構的支援,並在運算元效率和相容性方面表現出色。最後,她呼籲更多團隊參與構建這個開源生態系統。

3. 深入 Hugging Face Hub;在第一大 AI 中心,70萬+ PyTorch 模型的家園分享您的模型權重

來自 HuggingFace 的王鐵錚介紹了 HuggingFace Hub,這是一個常被稱為“AI 的 GitHub”的開源 AI 社群。它託管了大量的開源模型和資料集,並提供多樣化的功能:用於輕鬆測試模型的空間、核心、API 提供商閘道器、社交溝通功能以及與開源相關的指標。其模型庫提供按受歡迎程度和任務進行便捷過濾的功能,並設有熱門模型頁面,展示各種熱門模型。每個模型都有一個專門的頁面,顯示模型卡、程式碼和結構化資料。對於資料集,它支援 Git 倉庫,提供視覺化和 SQL 查詢功能,並提供強大的程式設計介面。

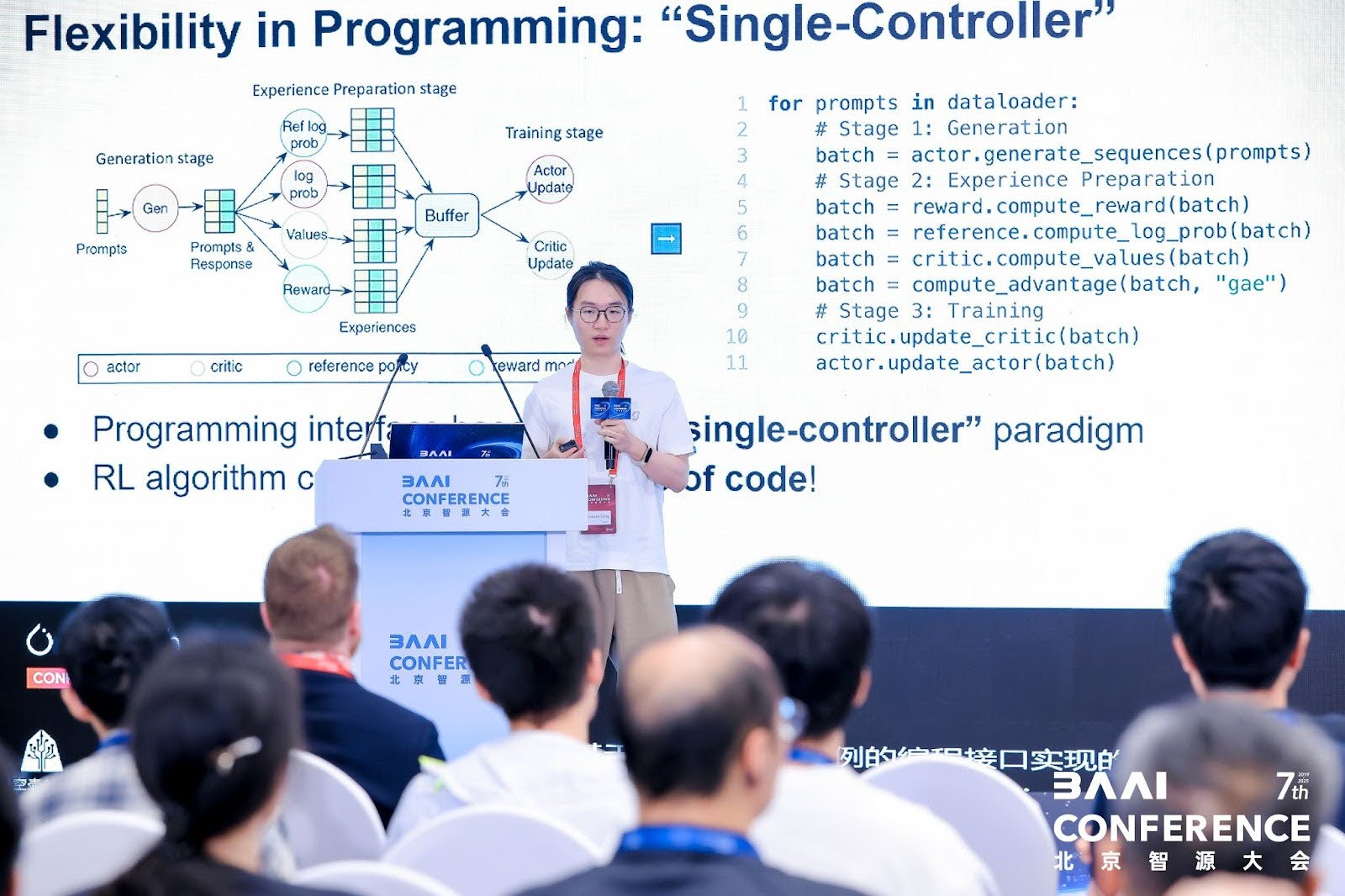

4. Verl:一個用於代理任務的開源大規模 LLM 強化學習框架

來自字節跳動的仝宇軒介紹了verl,這是一個開源的大規模 LLM 強化學習框架。他首先強調了大規模強化學習的重要性,它顯著增強了語言模型的效能,並在實際任務中具有廣泛應用。然而,它面臨著複雜的資料流(涉及多個模型、階段和工作負載)、分散式工作負載以及平衡資料依賴和資源約束的挑戰。Verl 的優勢在於平衡了靈活性和效率:它透過單一控制器正規化實現了程式設計靈活性,允許用最少的程式碼描述核心邏輯並支援多種演算法,並且它具有混合引擎以最佳化資源利用。該框架擁有一個活躍的開源社群,有幾個流行的專案都建立在其之上。最後,他分享了社群的未來路線圖並歡迎新成員。

5. PyTorch 在中國:社群增長、本地化與互動

來自華為的宗澤勝討論了 PyTorch 在中國的發展。作為全球流行的框架,PyTorch 擁有大量來自中國的貢獻者,在全球名列前茅。為了解決初學者本地化資源匱乏的問題,他們翻譯了 PyTorch 官方網站,建立了社群主頁,並翻譯了從初級到高階的教程。他們還透過聊天頻道(去年底建立)積極與使用者互動,釋出了60多篇技術部落格,並獲得了2500名訂閱者。未來的計劃包括進一步自動化翻譯,提供更多高質量的資源和活動,並邀請使用者參與。

6. AI 開源發展及其對 AI 生態系統的影響

CSDN 高階副總裁兼 Boulon 技術專家李建忠分享了對 AI 開源發展及其對 AI 生態系統影響的見解。他比較了全球和中國的 AI 技術生態系統,指出中國的 AI 開源在全球的重要性日益增加,並將 AI 的發展與地球上生物智慧的演變進行了類比。隨後,他討論了推理模型的發展,這些模型使大模型能夠“慢思考”,並減少對訓練語料庫中弱推理訊號的依賴,其中強化學習中的機器合成數據發揮著關鍵作用。他分析了開源對生態系統的影響,包括大幅降低模型訓練和推理成本,並推動 AI 應用向能夠規劃、協作和行動的代理發展。

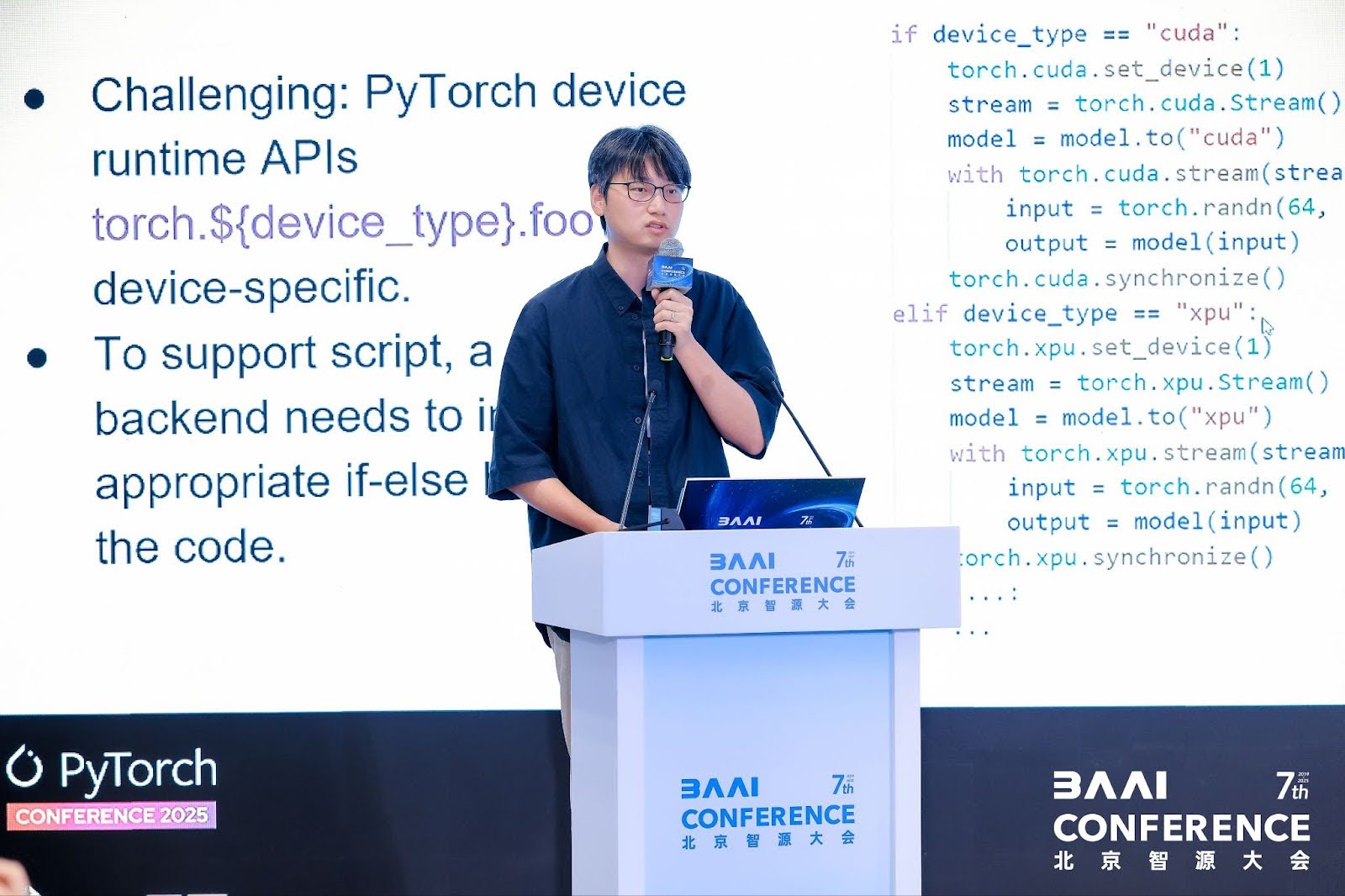

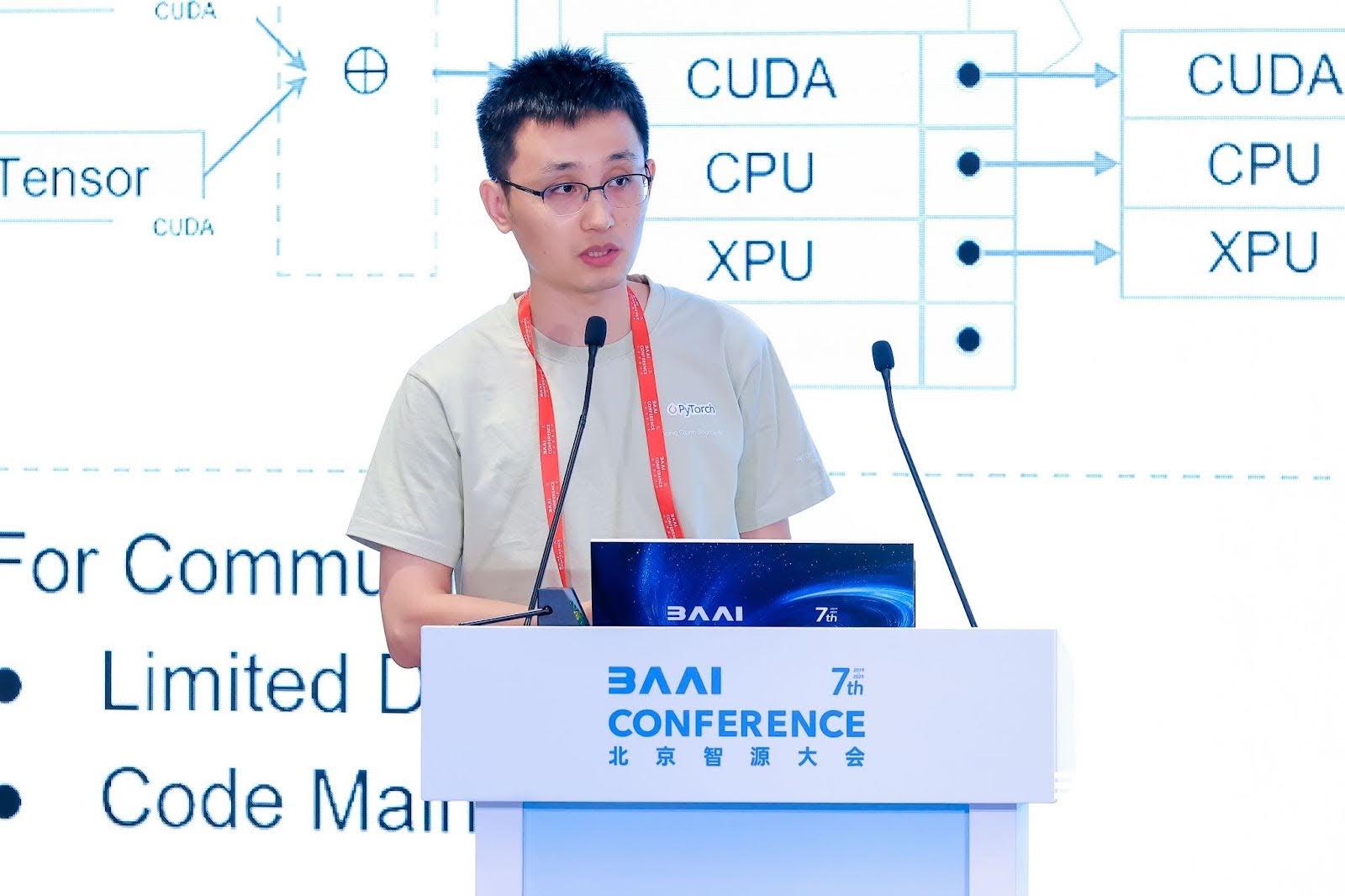

7. torch.accelerator:用於基於流的加速器的統一、裝置無關的執行時 API

來自英特爾的餘廣業介紹了 PyTorch 2.6 中推出的torch.accelerator API,這是一個用於基於流的加速器的統一、裝置無關的執行時 API。儘管 PyTorch 作為一個廣泛使用的機器學習框架支援各種加速硬體,但現有的執行時與特定的裝置模組耦合(例如,`torch.cuda.current_device` 僅適用於 CUDA 裝置),這限制了程式碼的可移植性,並給硬體供應商整合新後端帶來了挑戰。PyTorch 2.5 引入了加速器的概念,2.6 提出了一個統一的裝置無關的執行時 API,其功能與現有裝置特定的 API 緊密對映,以最大限度地減少程式碼遷移更改。未來的計劃包括新增記憶體相關的 API 和通用單元測試。最後,他感謝社群和貢獻者為這些改進所做的努力。

8. vLLM:人人都能輕鬆、快速、廉價地進行 LLM 服務

來自清華大學的遊凱超介紹了vLLM,旨在為所有人提供易於訪問、快速且經濟實惠的語言模型推理服務。它於2023年6月開源,憑藉近4.83萬的 GitHub 星標而受到廣泛關注。它易於使用,支援離線批處理推理和與 OpenAI 相容的 API 伺服器,並適用於各種模型型別。作為主要語言模型公司的官方合作伙伴,它可以在模型釋出後立即部署。vLLM 支援多種硬體,探索基於外掛的整合,並應用於日常生活和企業應用。它透過軟體包、Docker 映象、預編譯的 wheel 和強大的持續整合系統優先考慮使用者體驗。最後,他感謝 vLLM 社群的1100多名貢獻者。

9. 一個由 torch_musa 驅動的基於 torch.fx 的壓縮工具包

來自摩爾線程的莫凡介紹了torch_musa,這是一個 PyTorch 外掛,使 PyTorch 能夠在其平臺上原生執行,並具有高度最佳化的功能和運算元。隨後,他詳細介紹了壓縮工具包,解釋了選擇 FX(可除錯、易於修改圖、易於整合)的原因。其工作流程涉及輸入模型和配置檔案,在跟蹤階段捕獲完整的模型圖,並通過後端進行最佳化/縮減。他還介紹了定製最佳化和對多種資料型別的支援。未來的工作包括使大型語言和視覺模型可跟蹤、加速推理以及構建容錯系統。

10. 字節跳動影片生成基礎模型的高效訓練

來自字節跳動的張衡分享了字節跳動在影片生成基礎模型大規模、高效能訓練方面的經驗,包括在廣告、電影和動畫中的應用。他介紹了影片生成模型的結構(VE 編碼、MMDIT 擴散、VE 解碼)和訓練過程(分階段訓練,VE 編碼離線以最佳化儲存和預處理)。他還討論了影片生成模型中負載不平衡的挑戰和解決方案。

11. torch.compile 在不同場景下的實踐與最佳化

來自阿里雲的顏奕晨分享了團隊在 `torch.compile` 實踐與最佳化方面的經驗。`torch.compile` 透過圖捕獲、回退處理和最佳化核心生成等元件,僅用一行程式碼即可加速模型,但在生產環境中面臨挑戰。為解決這些問題,團隊解決了 Dynamo 和 DeepSpeed ZeRO/梯度檢查點之間的相容性,並向相關庫提交了整合解決方案;透過模式匹配識別並重寫注意力計算模式,以實現更好的融合和效能;優化了輸入對齊以減少不必要的重新編譯。他還提到了未解決的問題和未來方向:動態形狀的編譯策略、啟動延遲最佳化、減少開銷以及改進核心快取機制。

12. 生產環境中的 PyTorch:在昇騰 NPU 上加速 LLM 訓練和推理

來自華為的李嘉偉和李晶介紹了 PyTorch 生態系統中昇騰 NPU (torch_npu) 的進展。他們重點關注 PyTorch 上游多樣性支援,解釋了第三方裝置整合機制:使用基於 CPU 的模擬後端 OpenRag 作為測試後端來監控介面功能,並建立機制供下游硬體供應商在社群 PR 合併之前識別風險。

李晶分享了昇騰 NPU 的效能和生態系統支援。他介紹了torch_npu 架構以實現高效能和可靠性。目前已支援20多個流行庫,包括 vLLM、torchtune、torchtitan 等。他還解釋了 torch_npu 與 NPUGraph 和 torch.compile 協同工作的機制,以提供高效能計算。最後,他邀請大家加入社群並參加定期會議。

13. Hetu-Galvatron:一個用於高效大規模基礎模型訓練的自動分散式系統

來自北京大學的劉心怡和王宇傑詳細介紹了Hetu-Galvatron,這是一個基於 PyTorch 的創新系統,其主要特點是:自動最佳化、多功能性和使用者友好性。對於模型轉換,它基於原生 PyTorch 構建,透過替換支援張量和同步比較的層,將單 GPU 訓練模型轉換為支援多並行度的模型。對於自動最佳化,它擁有一個基於成本模型和搜尋演算法的引擎。它支援多樣化的模型架構和硬體後端,透過 PyTorch 確保與 GPU 和 NPU 的整合。它在不同的叢集和模型上表現出卓越的效率,並驗證了效能和準確性。未來的計劃包括整合 torch FSDP2,支援更多並行策略,更多模型和注意力型別,以及最佳化訓練後工作流程。

14. 英特爾的 PyTorch 之旅:提升 AI 效能並最佳化開源軟體

來自英特爾 PyTorch 團隊的馬明飛介紹了英特爾在 PyTorch 方面的工作。對於英特爾 GPU 上的 PyTorch 最佳化,英特爾在 Linux 和 Windows 上提供支援,涵蓋執行時、運算元支援、`torch.compile` 和分散式訓練。對於 `torch.compile` 中的 CPU 後端最佳化,團隊參與了架構設計,擴充套件了資料型別支援,實現了 gemm 模板的自動調優,支援 Windows,並持續改進效能加速。對於 DeepSeek 671B 完整版效能最佳化,團隊完成了 CPU 後端開發,取得了顯著的加速(預填充效能提升14倍,解碼效能提升2.9倍),支援多種資料型別,以低成本滿足了即時需求。

15. FlagTree:適用於多樣化 AI 晶片的統一 AI 編譯器

來自北京智源人工智慧研究院的孟春雷介紹了FlagTree,一個支援多樣化 AI 晶片的統一 AI 編譯器,也是 FlagOS 開源堆疊的關鍵元件。FlagOS 由智源研究院與多個合作伙伴共同開發,包括FlagGems(大型模型通用運算元庫)、FlagCX(多晶片通訊)以及並行訓練/推理框架,支援大型模型訓練和推理。他還介紹了 FlagTree 用於多後端整合的架構,以及正在開發的功能:基於註解的程式設計正規化、重構的 Triton 編譯器執行時等,透過相關最佳化顯著提升了效能。

16. KTransformers:釋放 MoE 模型 CPU/GPU 混合推理的全部潛力

來自清華大學的張明行博士介紹了KTransformers,即 Quick Transformers,這是一個構建在 HuggingFace 的 Transformers 之上的庫,旨在透過最佳化的運算元整合和資料佈局策略,釋放 MoE 模型 CPU/GPU 混合推理的潛力。最初設計為一個靈活的框架,用於整合各種運算元最佳化,它解決了由於模型更大和上下文更長而導致的推理成本上升問題。對於低吞吐量和併發場景,它透過將計算密集型部分解除安裝到 GPU,將稀疏部分解除安裝到 CPU(針對 DeepSeek 等模型量身定製),並具有靈活的配置,實現了低門檻模型操作。未來的重點包括注意力層稀疏化、新增區域性微調以及維護用於分散式推理的Mooncake專案,歡迎社群交流。

17. SGLang:一個用於大規模 LLM 服務的高效開源框架

來自上海交通大學的研究生殷梁生介紹了SGLang,一個用於大規模 LLM 服務的高效開源框架。作為一個性能領先的開源引擎,具有優雅、輕量級和可定製的設計,它被學術界以及微軟和 AMD 等公司採用,提供高效能的強化學習解決方案。其核心是 PD 解耦設計,解決了非解耦模式中的問題:延遲、計算-通訊不平衡和排程不相容。它透過負載均衡器路由請求,實現預取和解碼例項之間的 KV 快取傳輸。未來的計劃包括延遲最佳化、更長序列支援和整合資料並行注意力。擁有400多名貢獻者,它被多家企業使用。